Дополнительные действия

AZykov (обсуждение | вклад) Нет описания правки |

AZykov (обсуждение | вклад) Нет описания правки |

||

| Строка 38: | Строка 38: | ||

Необходимо понимать, что для работы больших моделей требуется достаточно мощный сервер с графическим ускорителем. Для исполнения LLM важными параметрами сервера являются ядра CPU, количество оперативной памяти, архитектура GPU и объем видеопамяти. | Необходимо понимать, что для работы больших моделей требуется достаточно мощный сервер с графическим ускорителем. Для исполнения LLM важными параметрами сервера являются ядра CPU, количество оперативной памяти, архитектура GPU и объем видеопамяти. | ||

Для установки сервисов LLM необходимо использовать отдельный сервер. | |||

Количество необходимой видеопамяти варьируется в зависимости от конкретной модели и её версии. Так, например, для корректной работы модели DeepSeek-R1-Distill-Qwen-32B требуется минимум 32гб видеопамяти, а для DeepSeek-R1-Distill-Qwen-1.5B - 2гб. Каждая из моделей обеспечивает различное качество ответов, а от мощности оборудования напрямую зависит скорость ответов и допустимая параллельная нагрузка. | |||

Конкретные требования к серверу сформировать очень сложно, так как постоянно выходят новые модели и их версии, выпускаются новые поколения оборудования. Желательно опираться на требования той модели, которая планируется к использованию. | Конкретные требования к серверу сформировать очень сложно, так как постоянно выходят новые модели и их версии, выпускаются новые поколения оборудования. Желательно опираться на требования той модели, которая планируется к использованию. | ||

| Строка 58: | Строка 60: | ||

= Установка языковых моделей = | = Установка языковых моделей = | ||

Так как платформа Эра использует подход RAG, в каждой инсталляции присутствует как минимум две модели - RAG (embedding) и LLM (сама языковая модель). | |||

Embedding-модель позволяет трансформировать текстовые данные (например, данные из базы знаний) в понятные для ИИ эмбеддинги, которые уже будут использоваться при обращении к языковой модели. | |||

Далее, рассмотрим два примера установки локальных моделей. | |||

=== Установка LocalAI === | |||

LocalAI - это проект с открытым исходным кодом, который предоставляет возможность локального развёртывания большого числа моделей и предоставляет для использования OpenAI-like API. Также он поддерживает загрузку моделей через web-интерфейс. Контейнер загружается из сети Интернет и при первом запуске автоматически скачивает модели по умолчанию). | |||

Работает на GPU. | |||

Установка выполняется одной командой:<syntaxhighlight lang="bash"> | |||

docker run --gpus all --name era_ai_llm_localai --publish 32081:8080 -dit --restart unless-stopped localai/localai:latest-aio-gpu-nvidia-cuda-12 | |||

</syntaxhighlight> | |||

[[Файл:Подключение LocalAI.png|мини|Подключение LocalAI]] | |||

Модели, используемые по умолчанию: | |||

* LLM: hermes-2-pro-mistral (alias gpt-4) | |||

* embedding (RAG): all-MiniLM-L6-v2 (alias text-embedding-ada-002) | |||

Для установки новых моделей используется web-интерфейс http://server_address:32081 | |||

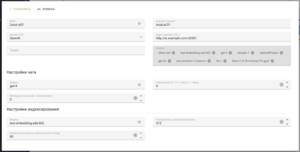

После установки контейнера, необходимо добавить новый сервис в приложении ИИ (в разделе Сервисы GPT). Пример настройки представлен на скриншоте. | |||

[[Категория:Приложения]] | [[Категория:Приложения]] | ||

Версия от 12:00, 14 июля 2025

Общая информация

В составе платформы Эра, начиная с версии 1.9, доступно приложение ИИ. Данное приложение позволяет использовать большие языковые модели (LLM) в рамках платформы.

На текущий момент, основным применением LLM в рамках платформы являются чат-боты.

Приложение ИИ предоставляет следующий набор возможностей:

- Подключение различных провайдеров LLM (с форматом API OpenAI и Ollama)

- Создание ботов, которые взаимодействуют с конкретным провайдером

- Создание файловых баз знаний для ботов

- Просмотр диалогов с ботами

Имеется возможность использовать как облачные решения, так и развернутые во внутреннем контуре модели.

При работе с искусственным интеллектом, платформа использует подход RAG, который позволяет комбинировать информацию, содержащуюся в самой модели (как правило только публичная и общая информация) с инфорамцией из конкретной базы знаний бизнеса. Этот подход позволяет значительно уменьшить количество "расплывчатых" ответов ИИ, а также ограничить его нецелевое использование - пользователям будет доступен контекст, определяемый базой знаний.

Все запросы к языковым моделям осуществляются не напрямую из платформы Эра, а через специализированный сервис Era AI Proxy, который предоставляет единый интерфейс для работы с моделями, осуществляя преобразование запросов в необходимый API внутри себя.

Установка сервиса AI Proxy

Сервис AI Proxy работает как отдельный docker-контейнер и является отдельным микросервисом, не входящим в контур платформы эра. Соответственно, он не управляется доменным центром эра, не осуществляется автоматическая миграция и сборка логов. Сервис может быть развернут как на одном из сервером, обслуживающем платформу, так и на отдельном сервере (например, отдельном сервере для LLM с GPU).

Установка контейнера сервиса выполняется несколькими простыми командами:

wget https://download.era-platform.ru/ai/era_ai_proxy_1_1_0.tar.gz

docker load -i era_ai_proxy_1_1_0.tar.gz

docker run --name era_ai_proxy \

--tmpfs /run:rw,noexec,nosuid,size=4096k \

--publish 32443:443 --publish 32080:8080 \

-dit \

--restart unless-stopped \

era/ai_proxy:1.1.0

После чего он становится доступен на портах 32443 (HTTPS) и 32080 (HTTP).

После запуска сервиса, необходимо в вашем основном (не мастер) домене, в приложении Администратор платформы, раздел Параметры -> Система, задать значение параметра ai.service.address (пример на скриншоте).

На этом настройка прокси заканчивается и можно переходить к установке и подключению моделей.

Подготовка сервера для LLM

Необходимо понимать, что для работы больших моделей требуется достаточно мощный сервер с графическим ускорителем. Для исполнения LLM важными параметрами сервера являются ядра CPU, количество оперативной памяти, архитектура GPU и объем видеопамяти.

Для установки сервисов LLM необходимо использовать отдельный сервер.

Количество необходимой видеопамяти варьируется в зависимости от конкретной модели и её версии. Так, например, для корректной работы модели DeepSeek-R1-Distill-Qwen-32B требуется минимум 32гб видеопамяти, а для DeepSeek-R1-Distill-Qwen-1.5B - 2гб. Каждая из моделей обеспечивает различное качество ответов, а от мощности оборудования напрямую зависит скорость ответов и допустимая параллельная нагрузка.

Конкретные требования к серверу сформировать очень сложно, так как постоянно выходят новые модели и их версии, выпускаются новые поколения оборудования. Желательно опираться на требования той модели, которая планируется к использованию.

Перед установкой любых контейнеров, использующих видеокарты, как правило, необходимо:

- обновить ядро Linux

- установить драйвер NVidia

- установить nvidia-container-toolkit

- проверить доступность видеокарт утилитой nvidia-smi

Обновление любого контейнера - это удаление и установка:

docker stop container_name

docker rm container_name

docker run --name container_name ...

Установка языковых моделей

Так как платформа Эра использует подход RAG, в каждой инсталляции присутствует как минимум две модели - RAG (embedding) и LLM (сама языковая модель).

Embedding-модель позволяет трансформировать текстовые данные (например, данные из базы знаний) в понятные для ИИ эмбеддинги, которые уже будут использоваться при обращении к языковой модели.

Далее, рассмотрим два примера установки локальных моделей.

Установка LocalAI

LocalAI - это проект с открытым исходным кодом, который предоставляет возможность локального развёртывания большого числа моделей и предоставляет для использования OpenAI-like API. Также он поддерживает загрузку моделей через web-интерфейс. Контейнер загружается из сети Интернет и при первом запуске автоматически скачивает модели по умолчанию).

Работает на GPU.

Установка выполняется одной командой:

docker run --gpus all --name era_ai_llm_localai --publish 32081:8080 -dit --restart unless-stopped localai/localai:latest-aio-gpu-nvidia-cuda-12

Модели, используемые по умолчанию:

- LLM: hermes-2-pro-mistral (alias gpt-4)

- embedding (RAG): all-MiniLM-L6-v2 (alias text-embedding-ada-002)

Для установки новых моделей используется web-интерфейс http://server_address:32081

После установки контейнера, необходимо добавить новый сервис в приложении ИИ (в разделе Сервисы GPT). Пример настройки представлен на скриншоте.